映像と音声を融合したイベント検索

概要

映像と音声を融合したイベント検索技術は、視覚情報と聴覚情報を統合的に解析することで、従来の単一モダリティでは実現できなかった高精度なイベント検出と検索を可能にします。

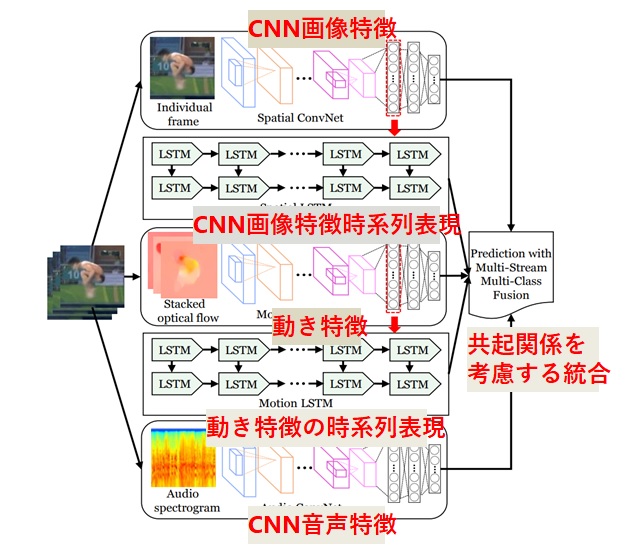

本研究では、映像クリップ単位の時系列情報を抽出し、音声と画像の共起関係を統合することにより、イベントごとの時系列を表現するマルチモーダルのEnd-to-End CNNフレームワークを開発しています。

研究内容

マルチモーダル特徴抽出

映像から抽出される視覚特徴と、音声から抽出される聴覚特徴を統合し、より豊かな情報表現を実現します。

時空間的統合

映像と音声の時間的・空間的な相関関係を考慮した統合処理により、イベントの正確な検出と分類を行います。

深層学習による最適化

ディープニューラルネットワークを活用し、映像・音声の特徴統合と分類を end-to-end で学習します。

応用分野

- 監視システムにおける異常イベント検出

- スポーツ映像の自動ハイライト生成

- 講義・会議の重要シーン抽出

- エンターテイメントコンテンツの検索・推薦

期待される成果

マルチモーダル解析により、従来手法と比較して検索精度の大幅な向上が期待されます。また、人間の認知プロセスに近い自然な情報処理が可能になります。